최근 3D 생성AI 기술은 컴퓨터 그래픽, 애니메이션, 패션, 게임, 교육 등 다양한 산업 분야에서 핵심 도구로 부상하고 있다. 기존의 수작업 중심 콘텐츠 제작 방식은 시간과 비용이 많이 소요되고, 고급 기술 역량을 요구한다는 한계가 있었다. 이에 따라 한 장의 이미지나 간단한 스케치만으로 고해상도 3D 콘텐츠를 자동 생성하고 시뮬레이션까지 가능한 생성AI 기술에 대한 수요가 급증하고 있다. 특히 몰입형 경험, 실시간 상호작용, 맞춤형 콘텐츠 제작 등 사용자 중심의 디지털 경험이 강조되면서, 보다 정교하고 물리적으로 정확한 3D 재구성 기술이 산업계의 주요 요구사항으로 자리 잡고 있다.

SIGGRAPH 2025는 이러한 기술 발전을 집중 조명하며 최신 연구 성과를 공유하는 장으로, 기술 트렌드와 시장 요구를 연결하는 플랫폼 역할을 수행하고 있다. 오는 8월 10일부터 14일까지 캐나다 밴쿠버에서 개최되는 ‘시그래프 2025(SIGGRAPH 2025)’에서는 다양한 컴퓨터 그래픽 및 인터랙티브 기술 분야의 연구를 선보인다.

CAST, 사실적 장면 재구성 기술의 진화

생성AI 도구는 개별 3D 객체 재구성에서 진전을 이루었지만, 여러 객체를 포함한 사실적인 장면을 재현하고 물리적 상호작용을 정확하게 포착하는 것은 여전히 과제로 남아 있다.

상하이과기대학교(ShanghaiTech University)와 디모스(Deemos)의 연구팀은 단일 사진에서 고품질 3D 장면을 재구성하는 혁신적인 방법으로 이러한 한계를 해결하고 있다. 단일 객체 3D 생성과 전체 장면 재구성 간의 격차 해소를 위해, 이 새로운 연구는 사실적인 3D 장면 생성의 정확성과 효율성을 향상시킨다.

상하이과기대학교 및 디모스의 연구원이자 ‘CAST: Component-Aligned 3D Scene Reconstruction From an RGB Image’ 프로젝트 책임자인 치쉬안(QX) 장(Qixuan (QX) Zhang)은 “의자 3D 모델과 같은 단일 객체 생성에서 전체 장면 생성으로의 이러한 도약은 AI가 생산 준비 단계에 접어들고 있는 생성AI 혁명의 일부이다.”라며 “이는 몰입형 디지털 경험을 만들고 스마트 기계를 훈련하는 방식을 변화시키고 있다.”라고 말한다.

연구팀은 고품질 단일 객체 3D 지오메트리 생성으로 사이그래프 2024에서 최우수 논문 후보에 오른 이전 연구 ‘CLAY’를 기반으로, 한 단계 더 나아가기 위해 CAST라는 새로운 접근 방식을 개발했다.

CAST는 CLAY의 이전 훈련 데이터 및 정확도 관련 한계를 해결한다. 광범위한 객체를 인식하고, 장면의 숨겨진 부분을 고려하며, 카메라 각도에 정확하게 일치시킬 수 있는 강력한 AI 모델을 결합함으로써 CAST는 단일 일반 사진에서 전체 3D 장면을 재구성할 수 있다. 연구팀은 그 결과가 사실적이며 물리적으로 정확한 환경을 생성한다고 말한다.

QX는 “거실 사진을 찍어 비디오 게임, 영화 또는 로봇 훈련을 위한 완전히 상호 작용 가능한 3D 장면으로 바꾸는 것을 상상해 보라. 모든 객체가 완벽하게 배치되고 컵이 테이블 위에 놓여 있거나 의자가 벽에 붙어 있는 것처럼 실제 세계에서와 같이 작동한다.”라며, “CAST는 누구나 단 한 장의 사진을 찍어 즉시 살아있고 현실과 일치하는 사실적인 3D 가상 세계를 만들 수 있는 미래에 더 가까워지게 한다.”라고 설명했다.

향후 연구에서 CAST 팀은 직물 및 유리와 같은 어려운 재료의 객체 세부 사항을 캡처하는 것과 같은 기존 한계를 해결하고, 조명 및 배경 모델링을 통합할 계획이다.

CAST 연구팀에는 QX와 함께 디모스 및 상하이과기대학교의 공동 연구자 카이신 야오(Kaixin Yao), 롱웬 장(Longwen Zhang), 신하오 얀(Xinhao Yan), 얀 젱(Yan Zeng), 웨이 양(Wei Yang), 란 쉬(Lan Xu), 지아위안 구(Jiayuan Gu), 징이 유(Jingyi Yu)가 참여한다.

스케치2애님, 스토리보드에서 3D 애니메이션으로

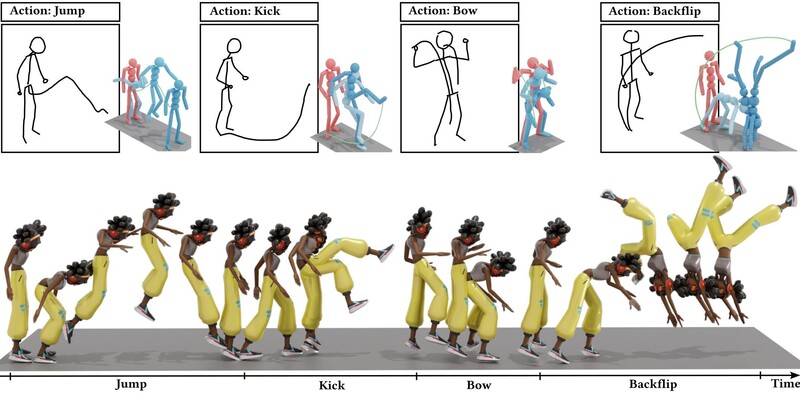

새로운 생성AI 방식이 2D 스토리보드 스케치를 정확한 3D 애니메이션으로 변환하고 있다. 컴퓨터 애니메이션에서 잘 탐구되지 않은 이 분야인 전통적인 스토리보드를 3D 프로세스로 전환하는 것은 ‘스케치2애님(Sketch2Anim)’이라는 새로운 도구를 통해 해결되고 있다.

이 새로운 방식은 스토리보드를 고품질 3D 동작으로 성공적으로 전송하며, 직접적인 3D 애니메이션 편집을 지원한다.

이 연구에서 에딘버러 대학교, 노스이스턴 대학교, 스냅(Snap)의 국제 연구팀은 모션 확산 모델(자연스러운 움직임을 프레임별로 생성하는 데 도움이 되는 AI 유형)의 발전을 활용해 2D 드로잉을 3D 애니메이션으로 자동 변환할 수 있는 새로운 접근 방식을 개발했다.

팀은 조건부 생성 접근 방식이라고 부르는 방법을 고안했다. 이 방법은 스토리보드에서 주요 신체 포즈, 움직임 경로 및 ‘달리기’, ‘점프’, ‘흔들기’와 같은 동작 단어를 조합해 걷기, 점프하기, 춤추기와 같은 사실적인 3D 동작을 생성할 수 있다.

이 방법의 일부는 사용자의 간단한 2D 스케치를 정확하고 정확한 3D 움직임과 일치시킬 수 있는 새로운 매핑 시스템을 포함한다. 연구팀은 이것이 2D 스토리보드에서 직접 3D 애니메이션을 생성하기 위해 모션 확산 모델을 적용한 첫 번째 접근 방식이라고 말한다.

이 연구의 주 저자이자 에딘버러 대학교 정보학부 조교수인 리창지안(Changjian Li)은 “이 작업은 상당한 실용적 중요성을 가지며 해당 분야에서 오랫동안 도전 과제였다.”라며, “우리의 방법은 이 복잡한 문제를 효과적으로 해결함으로써 상당한 기여를 한다.”라고 말했다.

현재 스케치2애님은 키 포즈와 움직임 경로를 포함하는 단순화된 스토리보드를 처리한다. 예를 들어, 캐릭터가 테이블이나 의자와 같은 장면의 한 물체를 뛰어넘거나 무릎을 구부리는 것 등이다. 그러나 실제 스토리보드는 훨씬 더 복잡하다.

향후 연구에서 팀은 현재의 한계를 해결하고 시스템 기능을 확장해 더 자세한 2D 스케치를 처리하고 이를 정확한 3D 애니메이션으로 변환할 계획이다. 또한 연구팀은 스케치에서 속도선을 해석해 속도 제어를 통합하는 것과 같은 제어 기능을 향상하는 방법을 모색하고 있다. 도구의 제어 기능을 향상하는 것은 향후 개발의 핵심 영역으로 남아 있다고 그들은 언급한다.

리(Li)는 “이 방법과 미래 개발을 통해 3D 애니메이션 산업은 전통적인 워크플로에서 벗어나 혁신적인 변화를 맞이할 준비가 되어 있다.”라며, “우리는 생성AI 기술이 비전문가에게 진입 장벽을 낮추고, 전문가의 효율을 높이며, 창의 산업 전반에 걸쳐 혁신을 가속하는 AI 지원 디자인 도구에 기여할 것으로 예상한다.”라고 덧붙였다.

드레스-원-투-쓰리, 단일 이미지로 구현하는 시뮬레이션 의류

패션 기술에 생성AI 도구를 통합하는 것은 빠르게 진화하고 있으며, 가상의 '구매 전 시착' 서비스는 사용자 경험을 한 단계 더 끌어올릴 수 있다. 이러한 혁신적인 도구들이 점점 더 인기를 얻고 있지만, 애니메이션 3D 패션 기술을 진정으로 사실적이고 쉽게 접근할 수 있게 만드는 데는 여전히 과제가 남아 있다.

캘리포니아 대학교 로스앤젤레스(University of California, Los Angeles)와 유타 대학교(University of Utah)의 컴퓨터 과학자 팀은 '드레스 원 투 쓰리(Dress-1-to-3)'이라는 새로운 생성AI 도구로 해결책을 제시한다.

이 새로운 종단 간 시스템은 단일 사진을 봉제 패턴, 질감, 재료 매개변수 및 포즈를 취한 인체까지 포함하는 완전히 분리 가능하고 시뮬레이션 준비가 된 3D 의류로 변환한다.

시그래프 2025 기술 논문 ‘Dress-1-to-3: Single Image to Simulation-Ready 3D Outfit With Diffusion Prior and Differentiable Physics’의 주 저자인 리 쉬안(Xuan Li)은 “다른 점은 결과물이 시각적으로 사실적일 뿐만 아니라 물리적으로 정확하며, 단 한 장의 평범한 이미지에서 옷 시뮬레이션, 가상 시착, 디지털 패션 워크플로우와 같은 하위 응용 프로그램에서 즉시 사용할 수 있다는 것이다.”라고 말했다.

드레스 원 투 쓰리는 사람의 단일 사진을 찍어 실제 직물처럼 보이고 움직이는 사실적인 애니메이션 3D 의류를 생성한다. 뻣뻣하거나 융합된 모델을 생성하는 다른 유사한 컴퓨팅 프레임워크와 달리, 이 도구는 셔츠, 바지 또는 드레스와 같은 분리된 의류를 생성해 패션 브랜드의 가상 시착 옵션이나 비디오 게임과 같은 디지털 시뮬레이션에서 자동으로 사용할 수 있다.

이 시스템은 사진에서 봉제 패턴을 예측하는 모델과 다양한 각도에서 의류를 상상하는 모델을 결합해 작동한다. 그런 다음 가상 직물 시뮬레이터를 사용해 결과물을 미세 조정해 옷이 사실적으로 움직이도록 지원한다.

리(Li)는 “특별한 장비는 필요 없다. 스마트폰만 있으면 된다.”라며, “이는 디지털 패션과 가상 드레스룸을 모든 사람이 접근할 수 있도록 하는 주요 단계이다.”라고 말했다.

이 연구에서 리와 팀은 이전 연구에서 직면했던 여러 장애물을 해결했다. 단일 사진은 일반적으로 깊이가 부족하고 폐색으로 인해 의류의 일부를 숨기는 경우가 많아 완전한 3D 재구성이 매우 모호하다.

새로운 도구는 의류가 다른 각도에서 어떻게 보이는지 상상하는 다중 시점 확산 모델을 사용해 이 문제를 극복한다. 이러한 합성 시점은 일관된 3D 형상을 생성하는 데 도움이 된다고 연구팀은 전했다. 또한 단일 의류의 더 좋고 최적화된 재구성을 초래할 수 있는 사진에서 얻은 복잡한 지오메트리를 재구성한다고 언급했다.

리(Li)는 “우리는 최첨단 옷 시뮬레이션 알고리듬인 Codimensional Incremental Potential Contact(C-IPC)를 미분이 가능하게 만들고, 시뮬레이션을 루프 내에서 최적화를 수행한다.”라며, “이 물리 기반 최적화를 통해 실제 조건에서 변형된 의류가 입력 이미지와 일치하도록 최적의 봉제 패턴 및 물리적 매개변수를 공동으로 결정할 수 있다.”라고 설명했다.

팀은 스마트폰으로 쉽게 캡처할 수 있는 비디오를 처리하도록 이 시스템을 확장할 기회를 보고 있다. 또한 의류가 어떻게 변형되는지에 대한 더 풍부한 정보를 제공하고 강성과 같은 물리적 특성 추정을 개선해 봉제 패턴 최적화에 도움을 줄 수 있다.

관련기사

- ‘AI 기반 비싱 대응 시뮬레이션’...조직 내 보이스 피싱 대응 역량 강화

- 라온메타-옐로우박스, ‘메타데미’에서 동력보트 조종 실습 콘텐츠 제공

- 국방 AI 역량 강화하는 '가상 전장 AI 시뮬레이션'...국가 및 동맹 위협 선제적 대응

- 웨어러블용 하이브리드 3D/2.5D 렌더링 지원 초저전력 오픈GL ES GPU 출시

- 피아이이-토모큐브, 홀로토모그래피 기반 검사 기술 개발로 산업 정밀 검사 분야 확장

- 3D 바이오프린팅·AI 결합 ‘맞춤형 잇몸 이식 기술’ 개발

- 팀뷰어, 하노버 메세 2025서 몰입형 ‘공간 컴퓨팅’ 솔루션 공개

- ‘아바타 SDK’ 카메라 영상으로 3D 아바타를 빠르고 쉽게!