초거대 AI 모델의 확산으로 데이터센터는 이전보다 훨씬 높은 연산 밀도, 대규모 병렬 처리, 빠른 추론 성능이 필요하다. 그러나 GPU 수요는 폭증하는 반면 전력·냉각·네트워크·스토리지 병목은 더욱 심화되고, 모델 운영에 필요한 자동화 역량도 한계가 있다. 특히 LLM 학습·추론 환경에서는 GPU 활용률 관리, 대규모 데이터 접근, 패브릭 구성 등 복잡도가 높아 기업들이 실제 AI 도입 효과를 체감하기 어려운 상황이다.

엔터프라이즈 IT 인프라 기업 델 테크놀로지(Dell Technologies, 이하 ‘델’)가 온라인 간담회를 개최하고, ‘슈퍼 컴퓨팅(SC25)’에서 공개하는 AI 인프라 핵심 포트폴리오를 발표했다.

델은 이번 간담회에서 ‘델 AI 팩토리 위드 엔비디아(Dell AI Factory with NVIDIA)’ 기반의 통합형 아키텍처 중심 혁신을 제시했다.

델 바룬 샤브라(Varun Chhabra) ISG 제품 마케팅 수석부사장은 “생성AI·HPC 워크로드가 급증하는 가운데, AI 도입의 가장 큰 장벽은 비용·교육·복잡성”이라며 “델 AI 팩토리(Dell AI Factory)는 이 문제들을 엔드투엔드 접근으로 해결한다.”라고 말했다. 그는 이번 발표에서 AI 인프라 병목 제거와 운영 복잡성 축소를 강조했다.

AI 인프라 전 계층 성능 강화

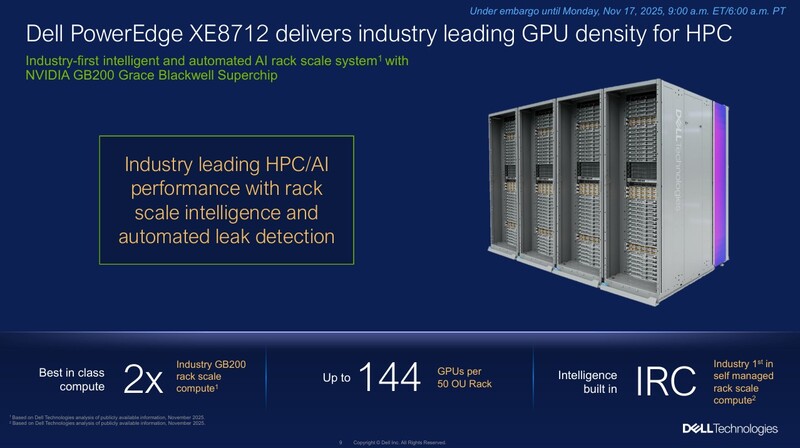

델은 AI 연산 성능을 극대화하기 위해 ▲서버 ▲네트워크 ▲스토리지 전 분야의 포트폴리오를 대거 확장했다. 가장 주목받은 제품은 단일 랙에서 144개의 엔비디아 GB200 그레이스 블랙웰(Grace Blackwell) GPU를 지원하는 ‘파워에지(PowerEdge) XE8712’다.

셀프 모니터링 AI 랙 스케일 시스템으로 개발된 이 제품은 통합형 IRC(Intelligent Rack Controller) 기술로 랙 전체의 상태를 스스로 감지하고 최적화한다. 이는 다운타임을 예방하고 GPU 자원을 최대한 활용해 AI 인프라 운영 효율을 높인다. 리퀴드 칩 쿨링과 통합 네트워킹 구조는 전력 효율과 발열 관리 성능을 향상하며, 대규모 LLM 학습·추론 환경에 최적화됐다.

샤브라 부사장은 “데이터센터는 이제 단순한 서버 집합이 아니라 하나의 시스템처럼 작동해야 한다.”라고 강조했다.

새로운 AMD 기반 AI·HPC 서버 ‘파워에지 XE9785’와 ‘XE9785L’도 공개됐다. AMD MI355X GPU 기반으로 기존 대비 최대 2.7배 빠른 MLPerf 학습 성능, 50% 확장된 HBM3E 메모리, 44% 향상된 메모리 대역폭을 제공하며, 공랭식·수랭식 중 선택할 수 있다.

초저지연 금융 트레이딩용 ‘파워에지 R770AP’은 인텔 제온(Xeon) 6 기반으로 기존 대비 최대 2.1배 성능 향상과 47%의 전력 효율 개선을 달성했다.

네트워크 자동화·지능형 패브릭 확장

네트워크 분야에서는 엔터프라이즈 소닉 배포판이 엔비디아 스펙트럼-X(Spectrum-X)를 정식 지원하며, 멀티 실리콘 아키텍처를 단일 운영체계에서 관리할 수 있는 기반을 마련했다.

델 스마트패브릭 매니저(Dell SmartFabric Manager)와 통합돼 복잡한 AI 패브릭 구축 과정에서 수작업 절차를 93%까지 줄일 수 있으며, 1.6TbE 대역폭을 제공하는 파워스위치(PowerSwitch) Z9964 시리즈는 최대 128K GPU까지 단 두 계층(two-tier) 패브릭에서 연결할 수 있어 네트워크 비용 절감 효과가 크다.

스토리지 성능 최적화…NIXL 기반 추론 가속

스토리지 역시 대규모 AI 워크로드 병목을 해소하기 위해 강화됐다.

파워스케일(PowerScale)은 pNFS 기반 병렬 I/O를 공식 지원하며, 최신 AMD CPU 기반 아키텍처로 최대 50% 높은 성능을 제공한다. 또한 파워스케일 소프트웨어가 2026년부터 독립형 제품으로 출시되며 더 빠른 하드웨어 혁신 주기를 지원한다.

오브젝트스케일(ObjectScale)은 S3 테이블과 S3 벡터 API를 통해 수십억 벡터를 1초 미만으로 검색할 수 있어, 별도의 벡터DB 없이 초고속 AI 검색 엔진을 구축할 수 있다.

여기에 델 스토리지와 엔비디아 ‘다이나모(Dynamo) NIXL’ 라이브러리를 통합한 새로운 KV-캐시 오프로딩(KV-Cache Offloading) 기술이 적용됐다. 파워스케일·오브젝트스케일 기반 스토리지로 vLLM KV 캐시를 오프로딩해 GPU 메모리 병목을 줄이고, 이를 통해 TTFT(Time to First Token)가 최대 19배 개선되며, LM 캐시 기반 추론 처리량 또한 최대 2.8배 증가한다. 이는 대규모 모델 추론 효율을 높이는 핵심 요소다.

AI 자동화·서비스 확장...도입 시간·비용 축소

AI 구축 복잡성을 줄이기 위한 자동화 기술도 강화됐다. 델 자동화 플랫폼(Dell Automation Platform)은 AI 워크로드를 10번의 클릭만으로 배포할 수 있으며, 30개 이상의 수작업 단계를 제거해 구축 시간을 66% 단축한다.

특히 이 플랫폼은 델 AI 팩토리 위드 엔비디아(Dell AI Factory with NVIDIA) 전체 아키텍처를 실제 인프라 구성까지 자동으로 전달하는 상위 관리 계층으로, 엔비디아 기반 서버·패브릭·스토리지 환경을 단일 인터페이스에서 일괄 배포·조율할 수 있다. 코히어(Cohere) 기반의 엔터프라이즈 AI 에이전트도 자동화 환경에서 즉시 배포 가능해 기술 인력 부족 문제를 해결한다.

샤브라 부사장은 “AI는 단순히 빠른 서버가 아니라, 빠르게 구축되고 운영되는 전체 플랫폼이 중요하다.”라고 말했다.

서비스 영역에서는 ‘AI 유즈케이스 파일럿(AI Use Case Pilot)’ 프로그램이 새롭게 발표됐다. 고객의 실데이터를 활용해 8주 이내에 AI 파일럿을 완성하도록 지원하며, PoC에서 운영 환경으로의 전환까지 엔드투엔드로 지원한다. 이를 통해 기업은 AI에 대한 ROI와 TCO를 사전에 검증할 수 있어 투자 리스크를 줄일 수 있다.

샤브라 부사장은 “고객이 AI를 운영하려면 가장 필요한 것은 검증된 엔드투엔드 레퍼런스와 빠른 구축 경험”이라며 “델은 3천여 AI 팩토리 구축 경험을 기반으로 기업이 가장 빠르게 가치를 얻을 수 있도록 지원하겠다.”라고 말했다.

키워드

관련기사

- 성공적인 AI 도입, ‘인프라·데이터보안·전문성’이 관건

- 델 테크놀로지스, ‘델 AI 데이터 플랫폼’ 업데이트

- 델 테크놀로지스, SMB 특화 친환경 PC ‘델 프로 에센셜’ 4종 출시

- 클라우데라-델 테크놀로지스, 프라이빗 AI 플랫폼 고도화...데이터 거버넌스·성능·비용 효율 결합

- 델 테크놀로지스, 프라이빗 클라우드 스토리지 AI 자동화·보안 복원력 강화

- 인텔 가우디3 통합 AI 서버...‘델 파워엣지 XE7740’

- 델 테크놀로지스 포럼 2025, 데이터 중심 AI 인프라 전략과 혁신 사례 공유

- 델 테크놀로지스, ‘파워프로텍트 데이터도메인 올플래시’ 신제품 공개

- 에퀴닉스-그록, 저지연 LPU 기반 AI 추론 인프라 아태지역 확산 협력

- 델 테크놀로지스-마이크로소프트, 클라우드 통합 생태계 강화...하이브리드 클라우드 통합 자동화 본격화