매개변수가 많은 대규모 언어 모델에는 엄청난 양의 계산 리소스와 에너지가 필요하며 점점 더 많은 사람들이 환경에 미치는 부담에 대해 우려하고 있다. 이러한 이유로 더 낮은 에너지 소비로 비슷한 정확도를 달성할 수 있는 제한된 매개변수 모델에 대한 연구가 활발해지고 있다. 이 접근 방식은 LLM에서 중요한 지식을 추출하여 더 적은 계산 리소스를 사용하는 새로운 유용한 모델을 개발하기 때문에 ‘지식 증류’라고 설명된다.

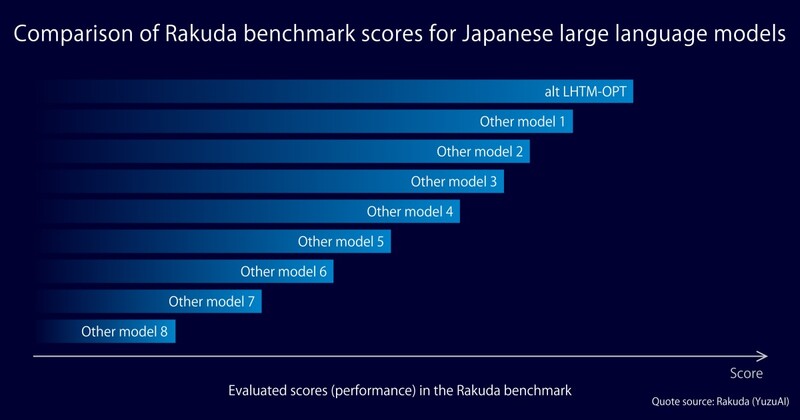

일본에 본사를 둔 AI 클론 및 개인 인공 지능(P.A.I.) 개발 업체인 알트(alt)는 소형 GPU 시스템에 최적화된 새로운 LLM(대형 언어 모델)인 LHTM-OPT를 발표했다.

고전적인 대형 언어 모델 LHTM-2는 수많은 매개변수와 매우 높은 자유도로 설정되었다. 이에 비해 LHTM-OPT는 매개변수 수가 LHTM-2의 5%에 불과한 경량 모델이며 소형 GPU 시스템에서 실제 온프레미스 사용에 최적화되어 있다.

LHTM-OPT를 개발하면서 알트는 공개 데이터에 대한 교육을 실시했을 뿐만 아니라 정확성을 높이기 위해 자체 지침 및 대화 데이터 세트를 만들었다.

알트 고객들은 새로 개발된 경량 및 고정밀 모델을 특정 분야에 맞게 미세 조정할 수 있다. 금융, 제약, 제조, 부동산 등 다양한 분야별 정보를 기반으로 LHTM-OPT를 맞춤화함으로써 많은 수의 매개변수를 사용하여 LLM과 동등한 전문성과 답변 정확도를 제공할 수 있다.

또한 경량화되고 정확도가 높은 모델을 운영함으로써 지속적인 사용에 따른 비용 효율성을 극대화할 수 있다.