LLM 모델의 평가는 목적과 용도에 따라 평가 축이 달라지기에 획일적으로 실시할 수 없다. 또한 새로운 모델이 계속 발표되고, 성능이 지속적으로 업데이트되는 최근에는 더 폭넓고 난이도가 높은 최신 평가 기법을 사용할 필요가 있다.

이에 W&B(Weights & Biases, CEO 루카스 비왈드)의 ‘호랑이(Horangi) 한국어 LLM 리더보드’는 평가에 다각적으로 접근하는 것을 통해 사용자가 모델을 획일적인 순위표로 비교하고 모델별 강점을 파악해 용도에 맞는 모델을 선택할 수 있도록 지원한다.

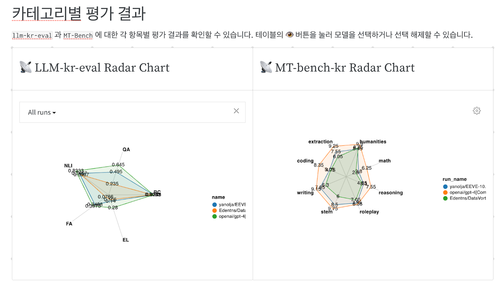

호랑이 리더보드는 W&B 플랫폼(WandB)의 주요 기능을 응용해 결과를 리포트에서 확인할 수 있으며 인터랙티브한 분석 기능을 제공한다. 공개 초기에는 20개 이상의 오픈 및 클로즈 모델의 평가 결과를 게시하고 기업이 프라이빗 환경에서 비공개로 모델 평가를 할 수 있도록 지원한다.

호랑이 리더보드의 지표는 크게 ‘언어 이해’와 ‘언어 생성’으로 분류된다. 언어 이해 태스크는 일문일답식 평가 체계를 사용하므로 입력된 내용을 정확하게 이해하고, 요구된 형식으로 답변하는 능력을 평가한다. 언어 생성 태스크는 자유 형식으로 모델에게 답변을 출력시키고, GPT-4를 사용한 정성적 평가를 수행한다. 이 평가 체계는 스태빌리티 AI(Stability AI)사의 MT-벤치(MT-Bench) 프레임워크를 활용하고 있다.

각 평가 카테고리는 구체적인 용도를 염두에 둔 하위 카테고리로 구성돼 있다. 언어 생성에서는 작문(writing), 추론(reasoning), 정보 추출(extraction) 등의 평가 축에서 모델의 강점을 검증할 수 있다.

호랑이 리더보드에서 사용하는 평가 방법은 대상 모델이 대화형 프롬프트에 대해 적절한 응답을 반환하는 것을 전제로 하고 있다. 이에 인스트럭션 튜닝을 통해 이른바 챗봇 능력을 획득하지 못한 모델에 대한 평가는 부적절하다고 할 수 있다.

호랑이 LLM 리더보드는 복잡한 머신러닝(ML) 개발 태스크를 자동화하는 ‘론치(Launch)’ 기능과 분석 결과를 집약 및 공유하는 ‘리포트(Reports)’ 기능 등 WandB의 주요 기능을 활용해 확장 가능하고 유연한 모델 평가 프레임워크를 제공한다. 이 프레임워크는 WandB를 사용하는 기업이 독자적으로 복제 및 실행할 수 있도록 지원하며, 결과를 공개하지 않고도 자사의 프라이빗한 환경 내에서 평가 결과를 다른 모델과 비교·검증할 수 있다.

WandB는 올해 4월 LLM 개발 지원에 특화된 각종 기능을 출시했을 뿐만 아니라 랭체인(LangChain), 라마인덱스(LlamaIndex) 등 주요 LLM 애플리케이션 개발 프레임워크와의 통합을 발표하며 이 새로운 패러다임에서의 개발 프로세스를 가시화하고 관리, 검증할 수 있는 플랫폼을 제공하고 있다. 국내에서는 리더스시스템즈, 펜타시스템과의 판매 파트너십 체결을 통해 지원 체제를 갖추고 있다.

키워드

관련기사

- [기고] 섀도 생성AI를 피하는 방법

- “디지털 시대의 경쟁력은 통합과 자동화”

- 기업의 생성AI 활용 극대화하는 LLM 제품군

- 보안 우려 없는 노코드 생성AI 어플라이언스

- AI 시대, 기업 비즈니스 향상시키는 데이터 솔루션 총망라

- GPT-4로 보안 위협 "자율적으로 해결"

- LLM 성능평가, 역사·독해력 등 지식의 ‘깊이’도 중요

- 생성AI와 노코드의 시너지 ‘효율성∙혁신∙성장’

- AI 비즈니스 성공하는 “데이터 관리·인사이트·보안” 혁신 전략

- RAG 핵심으로 부상하는 초고정밀도∙초고성능 LLM용 벡터 DB

- 말하면 알아서 척척 ‘절차 생성 AI’, LLM이 성능 보장

- W&B, GPT-4 기반 한국어 문서 발표

- 지식 자산화 솔루션과 sLLM의 결합 ‘M-LLM’

- 올거나이즈, 금융 LLM 리더보드·데이터세트 공개

- 엔비디아에서 라마3 최적화 하기

- 아이브릭스 LLM ‘세레브로’, Open-Ko-LLM 리더보드 1위 달성

- NIA-업스테이지, '오픈소스 한국어 LLM 리더보드' 평가 지표 개편