대규모 생성AI 모델은 방대한 연산 자원과 전력 소모를 필요로 하면서 기업과 산업 전반의 도입 장벽으로 작용해왔다. 특히 금융, 제조, 통신 등 데이터 보안과 실시간 응답성이 중요한 산업에서는 초거대 모델을 그대로 활용하기 어렵고, 고가의 GPU 인프라 투자 역시 한계로 지적돼왔다. 이에 따라 에너지 효율을 높이면서도 성능을 유지할 수 있는 모델 경량화 기술에 대한 수요가 커지고 있다.

글로벌 IT 기업 후지쯔(Fujitsu)가 생성AI 경량화를 위한 재구성 기술을 개발했다고 밝혔다. 이번 기술은 후지쯔의 생성AI 서비스 ‘코즈치(Kozuchi)’의 핵심 구성 요소로, 자체 개발한 대규모 언어 모델 ‘타카네(Takane)’ LLM을 기반으로 한다.

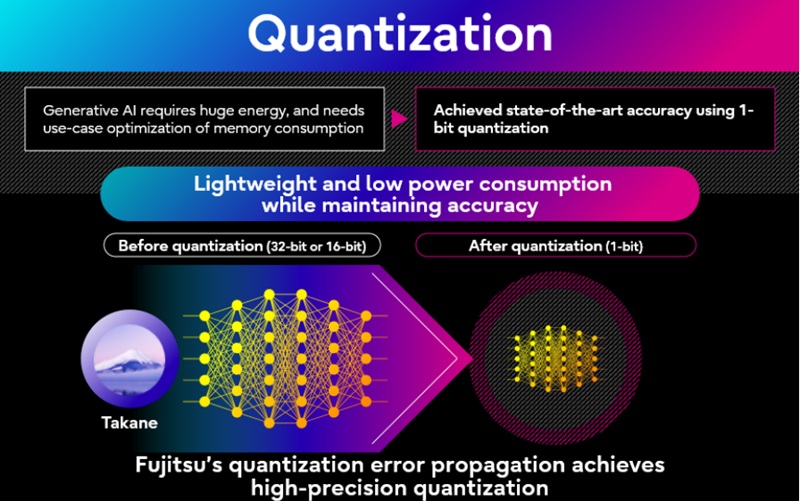

후지쯔는 독자적인 1비트 양자화 기술을 적용해 기존 모델 대비 메모리 사용량을 94%까지 줄였다. 이 과정에서도 원본 모델 대비 89%의 정확도를 유지한다. 그 결과 추론 속도가 3배 향상돼, 다수의 고성능 GPU를 필요로 했던 대규모 모델을 단일 저가 GPU 환경에서도 구동할 수 있게 됐다.

특화형 AI 증류로 성능 강화

후지쯔의 특화형 AI 증류 기술은 원본 모델보다 더 높은 정확도를 제공한다. 뇌의 학습 방식에서 착안한 이 접근법은 과제를 수행하는 데 필요한 핵심 지식을 추출하고 응축해, 특정 업무에 최적화된 고성능 AI를 구축할 수 있다. 이를 통해 경량화된 모델임에도 높은 신뢰성과 정확성을 동시에 확보한다.

이번 기술은 에이전틱 AI를 스마트폰, 공장 기계 등 에지 디바이스에 직접 탑재할 수 있는 가능성을 열었다. 실시간 반응성 개선, 데이터 보안 강화, 전력 소비 절감 효과를 동시에 실현해 지속가능한 AI 사회 구축에 기여할 것으로 기대된다. 이는 AI의 대중화를 가속화하고, 다양한 산업 현장에서 AI 활용도를 높일 수 있는 기반이 된다.

후지쯔는 2025 회계연도 하반기부터 이번 기술이 적용된 타카네 시험 환경을 제공할 예정이다. 또한, 허깅페이스(Hugging Face)를 통해 코히어(Cohere)의 오픈 웨이트(Command A) 모델을 양자화한 버전을 순차적으로 공개할 계획이다.

관련기사

- 실시간 에지 인프라 핵심 ‘포그 네트워킹’...스마트 산업 전환·AI 통합으로 연평균 43.5% 쾌속성장

- 스마트 시티 인프라 최적화 에지 AI 시스템...실시간 분석·멀티 디스플레이 구현

- 노타, 르네사스 MCU ‘RA8P1’에 AI 최적화 기술 탑재...50FPS 실시간 운전자 모니터링 구현

- ‘에지 AI SW’ 시장, 클라우드 의존 줄이고 실시간 데이터 처리 혁신하며 연평균 28.8% 급성장

- AI 기반 정밀 가격 예측 기술...마케팅 자동화로 마진 보호

- 5G·AI 시대, 실시간 산업 핵심 인프라 ‘멀티 액세스 에지 컴퓨팅’ 시장 연평균 43.6% 초고속 성장

- 딥엑스-한컴아카데미, AI 반도체 산업 교육·유통 생태계 확대

- 클라우데라 ‘AI-RAN 얼라이언스’ 합류...AI 기반 네트워크 혁신 가속화

- 실시간 위협 인텔리전스에 에이전틱 AI API 통합...사이버 보안 대응 속도 혁신

- AI 학습·추론 전 과정 자동화...개발 주기 단축과 성능 향상