알리바바 클라우드(Alibaba Cloud, CEO 에디 우)가 연례 행사인 ‘압사라 컨퍼런스(Apsara Conference)’에서 ▲새롭게 출시한 LLM 큐원2.5(Qwen 2.5) 100개 이상 오픈소스 커뮤니티에 배포 ▲텍스트와 이미지로 영상을 만드는 멀티모달 솔루션 ▲증가하는 AI 컴퓨팅 수요에 충족하는 풀스택 인프라도 개편 등을 지난 20일 발표했다.

특히, 이번에 발표된 신규 인프라는 컴퓨팅, 네트워킹 및 데이터센터 아키텍처를 강화하는 클라우드 제품과 서비스를 포함하며, AI 모델의 발전과 폭넓은 활용을 지원하는 데 초점을 맞췄다.

100개의 오픈소스 모델 공개

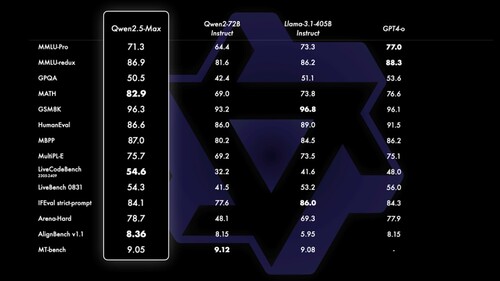

신규 오픈소스 큐원 2.5 모델들은 0.5억에서 720억 개의 매개변수를 갖추고 있으며, 지식이 향상되고 수학과 코딩 능력이 강화됐다. 29개 이상의 언어를 지원하며, 자동차, 게임, 과학 연구 등 다양한 분야나 에지나 클라우드 등 어떠한 환경에서도 AI 애플리케이션을 활용할 수 있다.

큐원(Qwen) 모델 시리즈는 알리바바 클라우드의 독자적인 LLM 포트폴리오로 허깅페이스(Hugging Face)와 알리바바의 오픈소스 커뮤니티 모델스코프(ModelScope)와 같은 플랫폼에서 4000만 건 이상의 다운로드를 기록했다.

이번 큐원 2.5는 100개 이상의 모델이 오픈소스로 공개됐다. 여기에는 기본 모델, 인스트럭트 모델, 다양한 정밀도와 방식을 적용한 양자화 모델이 포함되며, 언어, 오디오, 비전 등 다양한 모달리티와 전문적인 코드 및 수학 모델까지 포함한다.

멀티모달 분야 확장

알리바바 클라우드는 자사 LLM ‘스위트’ 외에도 이미지 생성기 ‘통이 완샹(Tongyi Wanxiang)’의 새로운 텍스트-비디오 모델을 공개했다. 이 모델은 현실적인 장면부터 3D 애니메이션까지 다양한 스타일의 영상을 생성할 수 있다.

또한, 중국어와 영어 텍스트 지시를 기반으로 영상을 생성하고, 스틸 이미지를 동영상으로 변환할 수도 있다. 또한, 향상된 영상 재구성을 위해 ‘확산 트랜스포머(Diffusion transformer, DiT)’ 아키텍처를 탑재하고 있다.

이외에도 알리바바 클라우드는 큐원2-VL(Qwen2-VL)이라는 자사 시각 언어 모델(Vision language model, VLM)도 도입하고 있다. 큐원2-VL은 20분 이상 길이의 영상을 이해하고, 영상 기반의 질문 응답도 할 수 있다. 추론 및 의사결정 기능을 갖춘 큐원2-VL은 핸드폰, 자동차, 로봇에 통합될 수 있도록 설계되어 특정 작업의 자동화도 지원한다.

또한 요구 사항 분석, 코드 프로그래밍, 소프트웨어 버그 식별 및 수정 등 작업의 자동화를 지원한 큐원 기반의 AI 어시스턴트 ‘AI 디벨로퍼(AI Developer)’도 출시했다.

풀스택 AI 인프라 업그레이드

한편 그린 데이터센터 아키텍처, 데이터 관리, 모델 학습 및 추론을 포함하는 자사 풀스택 AI 인프라에 대한 업데이트도 발표했다.

급증하는 AI 개발 수요에 대응하기 위해 알리바바 클라우드는 데이터센터 아키텍처 ‘큐브 DC 5.0(CUBE DC 5.0)’을 공개했다. 이 새로운 큐브 아키텍처는 공기-액체(wind-liquid) 하이브리드 냉각 시스템, 전직류(All direct current) 전력 분배 아키텍처, 스마트 관리 시스템으로 에너지 및 운영 효율성을 높였다. 또한, 사전 제작된 모듈형 디자인을 지원해 구축 시간을 단축한다.

한편 알리바바 클라우드는 점점 커지는 생성AI에 대한 수요 속에서 방대한 데이터를 관리하는 데 어려움을 겪는 조직들을 위해 빅데이터 엔진을 통합해 데이터 활용도를 극대화하는 '알리바바 클라우드 오픈 레이크(Alibaba Cloud Open Lake)' 솔루션을 선보였다.

이 플랫폼은 워크플로우 통합, 성능 최적화, 거버넌스를 하나의 플랫폼에서 제공하는 한편, 컴퓨팅과 스토리지를 분리하고 자원 사용을 효율화한다.

모델 학습 및 추론 작업을 통합한 ‘PAI AI 스케줄러’도 출시했다. 이 스케줄러는 컴퓨팅 자원 관리를 최적화하기 위해 설계된 클라우드 네이티브 스케줄링 엔진이다. 다양한 컴퓨팅 자원의 지능형 통합, 유연한 자원 스케줄링, 실시간 작업 조정, 자동 장애 복구를 통해 90% 이상의 효율적인 컴퓨팅 자원 활용률을 달성할 수 있다.

또한 기업들이 데이터를 효율적으로 관리하고, 그 가치를 극대화할 수 있도록 ‘DMS: OneMeta+OneOps’ 플랫폼을 도입했다. 이 플랫폼은 데이터베이스, 데이터 웨어하우스, 데이터 레이크 등 40가지 이상의 데이터 소스를 여러 클라우드 환경에서 통합 관리할 수 있게 해준다.

한편, 이번 컨퍼런스에서 9세대 엔터프라이즈ECS(Elastic Compute Service) 인스턴스도 소개했다. 이 최신 세대 ECS 인스턴스는 데이터베이스 제품에 적용 시 기존 모델 대비 검색 추천 속도가 30% 향상되고, QPS(Queries Per Second, 초당 쿼리 처리) 효율이 17% 개선되는 등 성능이 강화됐다.

알리바바 클라우드 인텔리전스 조우징런(Jingren Zhou) CTO는 "지금까지 가장 대규모의 오픈소스를 출시하는 중요한 전환점을 맞이했다."라며, "알리바바 클라우드는 다양한 산업에서 생성AI 기술의 광범위한 도입을 지원하기 위해 첨단 AI 인프라에 지속적으로 투자할 것을 약속한다."라고 말했다.

키워드

관련기사

- 데이터 폭증에 ‘클라우드 스토리지’ 급성장

- 알리바바 클라우드, “AI와 클라우드 기반 원격 생중계 지원으로 파리 올림픽 묘미 배가”

- 파리 올림픽 전력 걱정, 알리바바 클라우드 ‘에너지 엑스퍼트’로 해결

- 알리바바 클라우드, 생성AI 인재 양성에 적극

- 알리바바 클라우드, 멕시코에 첫 클라우드 리전 개설...3년내 한국에도 개설

- 알리바바 클라우드, LLM 신제품 ‘큐원2.5’ 및 플랫폼 업데이트 발표

- 데이터 활용의 기반 ‘데이터 레이크 시장’ 지평 확대

- 알리바바 클라우드, 퍼블릭 클라우드 가격 ‘최대 59% 인하’

- “중앙집중 데이터 아키텍처 문제, 데이터 가상화 기반 논리적인 데이터 관리로 해결”

- 메가존소프트, 알리바바 클라우드 ‘올해의 한국 파트너’ 수상

- 윈드리버, AI 워크로드 최적화하는 엔터프라이즈 리눅스 ‘엘릭사 프로’ 출시

- 지속 가능성 목표 달성, ‘디지털 도구’가 해법

- 알리바바, 자기 지도 학습 기반 기상 예측 모델 ‘바관’ 출시

- 알리바바 클라우드, AI·클라우드 기반 아시아 산업계 혁신

- AI, 사회적 가치 창출과 인류 문제 해결사로 부상

- 알리바바 클라우드, 전 세계 개발자 ‘최신 개발 툴, AI 인프라. 스타트업 지원 프로그램’ 지원

- 상업적으로 안전한 ‘AI 이미지 생성기’

- AI, 지속 가능성 앞당길 핵심 기술…관건은 '에너지 소비'

- 산업과 자동차 시장 혁신하는 ‘고신뢰성 스토리지’

- 알리바바 클라우드, 폴라DB로 TPC-C 벤치마크 세계 기록 달성