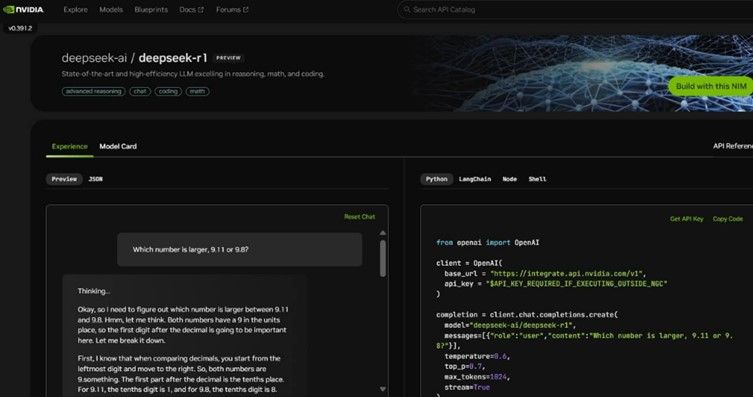

엔비디아가 자사의 NIM 마이크로서비스를 통해 최첨단 추론 모델 딥시크-R1을 지원한다고 밝혔다.

딥시크-R1은 여러 번의 추론 과정을 통해 최적의 답변을 생성하는 오픈 모델로, 논리적 추론과 사고, 수학, 코딩, 언어 이해 등 다양한 작업에서 높은 정확도와 효율성을 제공한다. 이를 통해 딥시크-R1은 AI 추론의 새로운 가능성을 제시하며 업계의 주목을 받고 있다.

딥시크-R1은 테스트 타임 스케일링 기업으로 실시간 추론과 고품질 응답을 모두 구현할 수 있는 역량을 보유하고 있다. 이 모델은 6710억 개의 파라미터와 12만8000개의 토큰을 처리할 수 있는 인풋 컨텍스트 길이를 자랑하며, 높은 대역폭과 짧은 지연 시간의 통신이 가능한 GPU 환경에서 최적의 성능을 발휘한다.

엔비디아는 NIM 마이크로서비스를 통해 개발자들이 이러한 첨단 기능을 안전하게 실험하고 맞춤형 AI 에이전트를 구축할 수 있도록 지원하고 있다.

NIM 마이크로서비스는 업계 표준 API를 지원해 배포를 간소화하며, 엔터프라이즈 기업들이 가속 컴퓨팅 인프라를 활용해 보안과 데이터 프라이버시를 극대화할 수 있도록 돕는다.

또한, 엔비디아의 네모 소프트웨어와 AI 파운드리를 통해 기업은 딥시크-R1을 기반으로 한 맞춤형 AI 솔루션을 개발할 수 있는 기회를 제공받게 된다. 이로써 엔비디아는 AI 추론 기술의 발전을 이끌며, 다양한 산업 분야에 혁신적인 변화를 가져올 것으로 기대된다.

배성철 기자

epsilondelta@gttkorea.com

관련기사

- 올거나이즈, LLM 에이전트 성능 평가 플랫폼 ‘올인원 벤치마크’ 공개

- AWS, 딥시크-R1 모델 제공

- 안전성·보안성 강화된 AI 모델 제어 플랫폼, 딥시크 R1 통합

- ‘딥시크 편향률 76% 감소’ AI 모델...공정성 높이고 성능은 그대로

- 주목받는 딥시크와 챗GPT 속 'AI 환각'...현실과 잘못된 정보의 위험

- 딥시크, AI 검색 시장에서 챗GPT 앞질러

- 14B 한국어 AI 모델, ‘생각 프로세스·테스트 시간 스케일링’으로 GPT-4o 능가

- 스노우플레이크, 코텍스 AI에서 딥시크-R1 지원

- 엔비디아 NIM·NeMo로 ‘AI·개발 프로세스 통합’...SW 개발 속도 단축

- 다올티에스, “교육·온디바이스AI·피지컬AI 협업으로 AX 가속화”

- 엔비디아, AI 모델 성능 높이는 '스케일링 법칙' 공개

- 몬드리안AI, GPU 클라우드 플랫폼에 딥시크-R1 모델 지원

- 팔로알토 네트웍스, 딥시크에서 보안 취약점 발견

- 시스코-엔비디아, 기업 AI 워크로드 최적화 통합 아키텍처 공동 개발

- 오픈 소스 AI 모델 ‘잠바 1.6’...장문 처리 성능 속도·정확도·보안↑

- 엔비디아, 개방형 AI 추론 모델 '라마 네모트론'출시

- 엔비디아, AI 에이전트 워크플로 간소화하는 NIM 마이크로서비스 출시