AI 기술이 대규모 언어 모델(LLM)과 생성AI 기반 애플리케이션 중심으로 발전하면서, 엔터프라이즈 환경에서의 AI 모델 배포와 운영 효율성 확보가 핵심 과제로 부상하고 있다. 특히 다양한 인프라 환경에 걸쳐 추론 워크로드를 안전하게 확장하고, 복잡한 설정을 줄이며 보안을 확보하는 기술이 요구되고 있다.

엔터프라이즈용 AI 인프라 플랫폼 기업 클리어ML(ClearML)이 AI 추론 마이크로서비스 ‘엔비디아 님(NVIDIA NIM)’과 통합 솔루션을 발표했다. 이번 통합 솔루션은 LLM 및 기타 고성능 AI 모델의 배포, 확장, 보안을 간소화하며, 데브옵스(DevOps) 병목 없이 프로덕션 수준의 운영을 가능하게 한다.

인프라 자동화·보안 강화 통합으로 AI 추론 배포 단순화

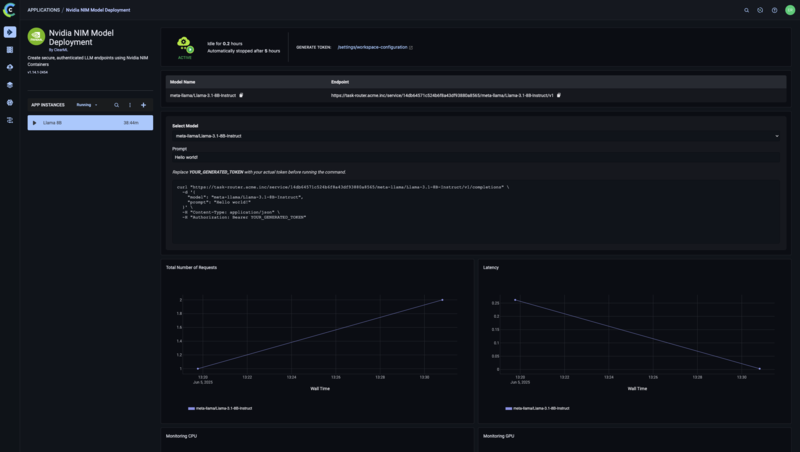

클리어ML은 이번 통합을 통해 복잡한 컨테이너 구성, GPU 프로비저닝, 네트워킹, 인증 및 액세스 보안 등 모델 배포의 주요 난점을 제거했다. 사용자는 베어 메탈, 가상 머신, 쿠버네티스 등 환경에 상관없이 단 몇 번의 클릭만으로 NIM 컨테이너를 안전하게 배포할 수 있다. 플랫폼은 네트워크 설정, 리소스 할당, 인증 관리까지 자동으로 처리한다.

NIM은 추론 엔진과 모델 체크포인트를 분리한 단일 컨테이너 구조로, 모델 변형의 유연성을 제공한다. 엔비디아 텐서RT-LLM(TensorRT-LLM) 등의 엔진은 지속 관리되는 컨테이너 내에서 실행되며, 외부에서 모델만 플러그인하는 방식으로 업데이트 유연성과 보안성, 프로덕션 준비도를 모두 향상시킨다. 이 모듈형 아키텍처는 다양한 LLM을 지원하고, 반복 속도와 런타임 효율성을 동시에 개선한다.

클리어ML은 이러한 구조에 보안 기능과 관측 기능을 더해, 자동화된 리소스 스케줄링, 역할 기반 액세스 제어(RBAC), 다중 테넌트 환경 지원, 실시간 엔드포인트 모니터링을 제공한다. 모든 배포는 ClearML의 단일 UI와 대시보드에서 통합 관리된다.

데브옵스 병목 제거, AI 서비스 확산 가속화

클리어ML은 추론 인프라 구성의 복잡성을 추상화함으로써, 온프레미스 또는 클라우드 환경에서 맞춤형 스크립트나 수동 설정 없이도 AI 서비스를 손쉽게 운영할 수 있도록 지원한다. 자동 확장, 워크로드 오케스트레이션, 할당량 관리 등 클리어ML 플랫폼 기능과 결합해 기업의 AI 생산성과 운영 효율성을 동시에 끌어올린다.

NIM 통합 배포는 기존 데브옵 중심의 수작업 방식보다 빠르고 안전하며 일관성 있게 AI 서비스를 제공할 수 있도록 설계되었으며, 개발자와 인프라 팀, 플랫폼 엔지니어들에게 통합적인 이점을 제공한다.

클리어ML 플랫폼은 AI 팀이 추론 워크로드를 클라우드, 온프레미스, 하이브리드 환경 어디에서든 실시간으로 확장 가능하게 한다. 단일 컨테이너 기반 배포 모델은 운영 간소화뿐 아니라 보안성도 확보할 수 있게 해준다.

클리어ML 모세스 굿트만(Moses Guttmann) 공동창업자 겸 CEO는 “엔비디아 NIM은 고성능 AI 모델 서빙을 매우 쉽게 만들어주고 클리어ML은 인증, RBAC, 보안 멀티테넌시 등 기능을 추가하며 배포 경험을 극대화한다.”라며 “이 통합을 통해 AI 팀은 온프레미스, 클라우드, 하이브리드 환경 전반에서 추론 워크로드를 즉시 확장할 수 있다.”라고 말했다.

관련기사

- 효율적인 RAG 시스템 구축법...벡터 이미지 검색·데이터베이스 통합

- 엔비디아, AI 에이전트 워크플로 간소화하는 NIM 마이크로서비스 출시

- 엔비디아 NIM·NeMo로 ‘AI·개발 프로세스 통합’...SW 개발 속도 단축

- A10 네트웍스, AI 및 LLM 추론 최적화 고성능 보안 인프라 기술

- 레드햇-구글클라우드, 기업용 AI 추론 성능 향상 및 에이전틱 AI 기술 협력 확대

- AI 고도화하는 맞춤형 풀스택 스토리지

- 고성능 GPU 인프라 결합으로 강화되는 멀티모달 추론 모델

- 레드햇, ‘RHEL 10’ 및 ‘AI 인퍼런스 서버’ 공개...생성AI·보안·클라우드 운영 최적화

- 서비스나우-엔비디아, 고성능 AI 추론 모델 개발...추론 정확도·속도 향상

- 넷앱-인텔, 통합 AI 추론 솔루션...추론 간소화로 빠른 AI 도입과 비용 절감 효과↑

- 엔비디아, 스마트 시티 AI 구현 가속화하는 ‘옴니버스 블루프린트’ 공개

- AI 기반 테스트 자동화로 회귀 시간 50% 단축

- 엔비디아, 양자화·텐서RT 최적화로 ‘스테이블 디퓨전 3.5’ 성능 2배↑

- 체크포인트, AI 위협 방지 성능 4배 강화된 보안 게이트웨이 출시

- AI 기반 사이버 위협 고도화, 방어 전략도 AI 중심으로

- AI·애플리케이션 보안, ‘강화된 런타임’으로 침해 발생전 차단

- 체크포인트, 포레스터 웨이브 '2025년 3분기 제로 트러스트 플랫폼 부문' 리더 선정

- 초고속 AI 추론 모델 '오픈AI gpt-oss-120B·20B' 전 세계 실시간 활용