생성AI 모델이 빠르게 고도화되면서 초대형 모델 훈련, 실시간 추론, 에이전틱 AI 시스템 등 복잡하고 고성능의 AI 워크로드를 지원할 수 있는 컴퓨팅 인프라의 필요성이 커지고 있다. 특히 조 단위 매개변수 모델, 고밀도 연산, 대규모 분산 학습 및 추론을 위한 안정적이고 확장 가능한 환경이 기업 및 연구기관에서 중요한 기술 인프라로 부상하고 있다.

이에 따라 글로벌 클라우드 기업들은 초고성능 GPU와 고대역폭 네트워크를 기반으로 한 인프라 개발에 집중하고 있으며, 고성능과 효율성, 보안성을 동시에 만족시키는 솔루션 도입이 가속화되고 있다.

AWS, 블랙웰 기반 AI 인프라 제품 2종 출시

아마존웹서비스(Amazon Web Services, 이하 AWS)는 15일, 엔비디아 블랙웰(NVIDIA Blackwell) 기반 AI 인프라 제품군으로 ‘P6e-GB200 울트라서버’와 ‘P6-B200 인스턴스’를 공식 출시했다고 밝혔다. 이 제품들은 추론 모델, 에이전틱 AI 시스템 등 차세대 생성AI 워크로드를 위한 고성능 컴퓨팅을 목표로 개발되었다.

P6e-GB200 울트라서버는 최대 72개의 엔비디아 블랙웰 GPU와 13.4TB 고대역폭 GPU 메모리, 360페타플롭스의 FP8 연산 성능을 갖춘 단일 컴퓨팅 유닛이다. 5세대 NV링크(NVLink)를 통해 연결된 이 시스템은 P5en 인스턴스 대비 20배의 성능과 11배의 메모리를 제공한다.

P6-B200 인스턴스는 8개의 블랙웰 GPU와 1.4TB 메모리, 최대 3.2Tbps의 네트워크 대역폭을 제공하며, P5en 대비 최대 2.25배의 연산 성능 향상을 지원한다. 중대형 AI 훈련과 추론 워크로드에 적합하며, 기존 인프라에서 최소한의 코드 수정으로 마이그레이션이 가능하다.

울트라급 연산과 네트워크 구조로 대형 모델 처리 최적화

P6e-GB200 울트라서버는 조 단위 파라미터 모델의 훈련 및 추론을 위한 고밀도 연산 환경을 제공하며, GB200 NVL72 아키텍처로 설계됐다. 이 구조는 GPU 간 통신 오버헤드를 줄이고, 분산 훈련 효율성을 높이며, 단일 NV링크 도메인 내에서의 추론 속도를 향상시킨다. 전문가 혼합 모델이나 초대형 컨텍스트 윈도우를 요구하는 애플리케이션에서 특히 높은 성능을 발휘한다.

P6-B200 인스턴스는 기존 GPU 워크로드와 호환되도록 설계된 구성으로, 인텔 제온 기반 x86 환경에 최적화돼 있다. 엔비디아의 AI 소프트웨어 스택은 ARM과 x86 모두에 최적화돼 있지만, x86 워크로드에는 P6-B200이 더 유리한 선택이다.

냉각 기술과 니트로 시스템 통한 인프라 효율성과 보안 강화

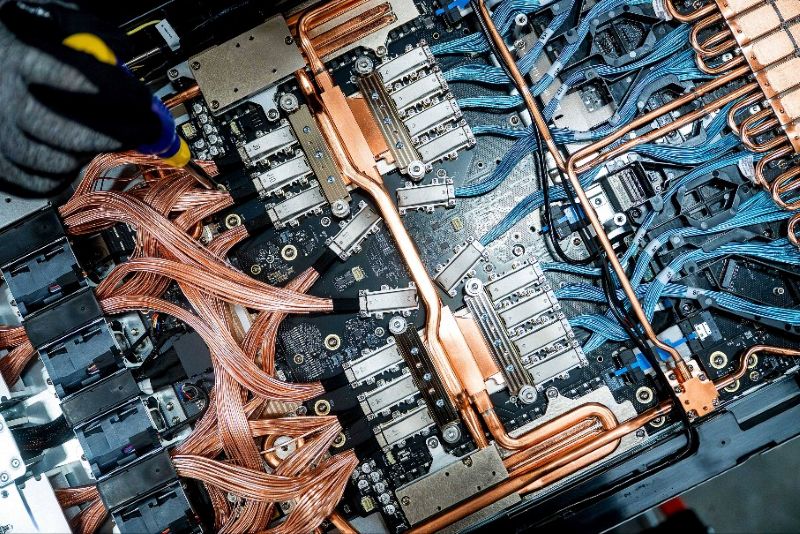

P6e-GB200 울트라서버는 액체 냉각 기술을 적용한 블랙웰 GPU의 높은 발열을 제어하기 위한 ‘리퀴드 투 칩’ 냉각 구조를 채택했다. 공랭 인프라와 함께 사용 가능한 이 설계는 신규 및 기존 데이터센터 모두에서 운용이 가능하며, 시스템 밀도와 냉각 효율을 동시에 확보할 수 있다.

P6-B200은 검증된 공기 냉각 인프라를 활용해 일관된 운영을 지원한다. 두 제품 모두 AWS의 6세대 니트로 시스템(Nitro System)을 탑재해, 운영 중단 없는 ‘라이브 업데이트’ 기능과 하드웨어 보안 설계로 안전한 AI 환경을 제공한다. 니트로 시스템은 네트워크, 스토리지, 펌웨어까지 전 영역의 제어 권한을 엄격히 제한해 고객 데이터를 보호한다.

AWS는 P6e-GB200 울트라서버를 3세대 EC2 울트라클러스터에 배치하여, 전력 소비는 최대 40%, 케이블링은 80% 이상 줄이는 동시에 대규모 운영 환경에서의 신뢰성과 확장성을 확보했다. EFAv4(Elastic Fabric Adapter v4)를 기반으로 하는 네트워크는 이전 세대 대비 최대 18% 향상된 집합 통신 성능을 제공한다.

SRD(Scalable Reliable Datagram) 프로토콜을 적용한 EFA는 다양한 네트워크 경로로 트래픽을 분산시켜 장애 상황에서도 성능을 유지하며, 고성능 AI 워크로드에서 요구되는 낮은 지연시간과 높은 처리량을 동시에 실현한다.

세이지메이커·EKS·DGX 클라우드로 활용성 확대

AWS는 P6e-GB200과 P6-B200 인프라를 아마존 세이지메이커 하이퍼팟(Amazon SageMaker HyperPod)에서 지원한다. 이 플랫폼은 GPU 클러스터의 프로비저닝, 오류 복구, 리소스 모니터링, 학습 계획 설정을 포함한 통합형 관리 기능을 제공한다. 하이퍼팟은 워크로드를 단일 NV링크 도메인 내에서 운영하도록 최적화되어 있다.

또한, 아마존 EKS(Amazon Elastic Kubernetes Service)는 쿠버네티스 기반의 워크로드 운영을 위한 관리형 노드 그룹과 오류 탐지 및 복구 기능을 갖췄다. 토폴로지 인식 기능을 활용해 P6e-GB200의 노드를 자동 라벨링하고, 워크로드를 최적의 위치에 배치할 수 있도록 지원한다.

P6e-GB200은 엔비디아 DGX 클라우드(NVIDIA DGX Cloud)를 통해서도 제공된다. DGX 클라우드는 엔비디아의 AI 소프트웨어 스택과 전문가 서비스를 통합한 플랫폼으로, 고성능 다중 노드 훈련 및 추론 환경을 제공하며, AI 이니셔티브를 빠르게 확장할 수 있도록 지원한다.

AWS는 “블랙웰 기반 AI 인프라는 단일 기술 혁신이 아니라, AWS의 컴퓨팅, 네트워킹, 운영 전반에 걸친 지속적인 혁신의 결과”라고 설명했다. 이번 출시를 통해 고객은 클라우드에서 초대형 모델 훈련과 실시간 생성AI 응답 성능을 동시에 확보할 수 있으며, 보안성과 효율성, 유연한 운영 모델까지 아우를 수 있는 환경을 갖출 수 있다.

관련기사

- 슈나이더 일렉트릭, 고밀도 AI 클러스터 대응 데이터센터 인프라 솔루션 출시

- PCIe 5.0 기반 국산 고성능 AI 서버 ‘클라이맥스-408’...AI 인프라 시장 본격 출사표

- AI 고성능·지속가능성 갖춘 ‘통합 냉각 솔루션’…데이터센터 에너지·운영 효율↑

- HPE-엔비디아, AI 팩토리 포트폴리오 강화

- 고성능 AI PC부터 500Hz OLED까지, 차세대 개인화 컴퓨팅 비전

- 예측 인텔리전스 기반 AI 스토리지 최적화 기술...AI 데이터 스토리지 효율성·지속가능성 향상

- 나무기술, S사 AI 서버팜 구축 사업 수주...멀티 쿠버네티스 클러스터 통합 관리

- 키옥시아, AI 애플리케이션용 고용량 122.88TB SSD 출시

- “클라우드와 AI에 투자 확대하는 금융권”...AWS, 한국 금융권 혁신 로드맵 공개

- 데이터센터 침지 냉각, TCO 계산기로 에너지·공간·비용 절감 효과 톡톡

- AWS, 국내 다기관 신약 개발 프로젝트 ‘K-멜로디’ 지원

- AWS, AI 출력 정확성 99% 보장 ‘자동 추론 검사’ 서비스 출시

- AWS, 생성AI 에이전트코어와 키로로 기업 생산성과 보안 동시 강화

- 반도체 칩 과열 문제 해결사, ‘실시간 열 분석 도구 타스칩’...차세대 컴퓨팅 혁신 열쇠

- 하드웨어 보안 모듈, 코드 위변조 차단과 포스트 양자 암호화 대비

- AWS, ‘베드록 에이전트코어’로 산업 AI 프로덕션 시대 연다